16. Juli 2024

KI-Ausblick in die nächsten 10 Jahre mit Regina Burgmayr, Project Manager & Business Development, Tawny.AI

Zwischen Technologie & Menschlichkeit: Wie Emotion AI Medien und Gesellschaft transformiert

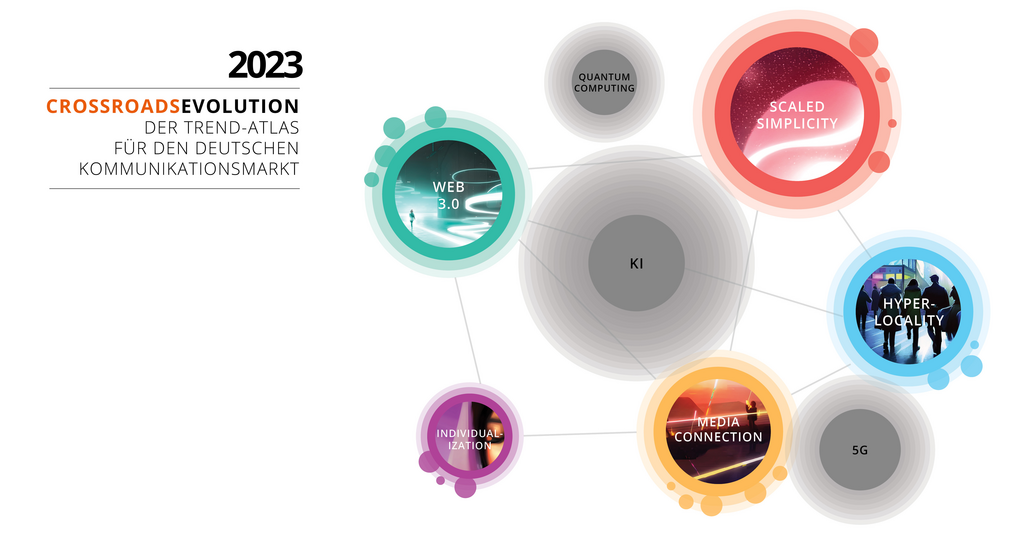

Vor kurzem haben wir unser Crossroads Essay „The Future of AI“ veröffentlicht. Was wir über KI wissen und welche Auswirkungen sie in den nächsten 10 Jahren auf den deutschen Medien- und Kommunikationsmarkt haben wird. Mit unserer begleitenden Blogserie möchten wir euch vertiefende Insights externer Expert:innen an die Hand geben und die Serie mit einem Gastbeitrag von Regina Burgmayr, Project Manager & Business Development von Tawny.AI, fortsetzen.

Regina Burgmayr verfügt über einen M.Sc. in Wirtschaftswissenschaften mit Schwerpunkt auf Marketing, Strategie und Führung sowie einen B.Sc. in Sport. Während ihres Studiums sammelte Regina Fachwissen in Psychologie und menschlicher Biomechanik. AI und Algorithmen sind ihr „tägliches Brot“ und sie hat in den vergangenen Berufsjahren einen starken Fokus auf Emotionsforschung gelegt. Bei TAWNY ist Regina unter anderem für Projektmanagement und Kundenorientierungsforschung verantwortlich, wobei sie erfolgreich Plattformprojekte koordiniert.

Die Schwelle zur emotionalen Intelligenz

„Technologie dringt immer tiefer in unseren Alltag ein und gerade mit Emotion AI eröffnen wir ganz neue Horizonte.“

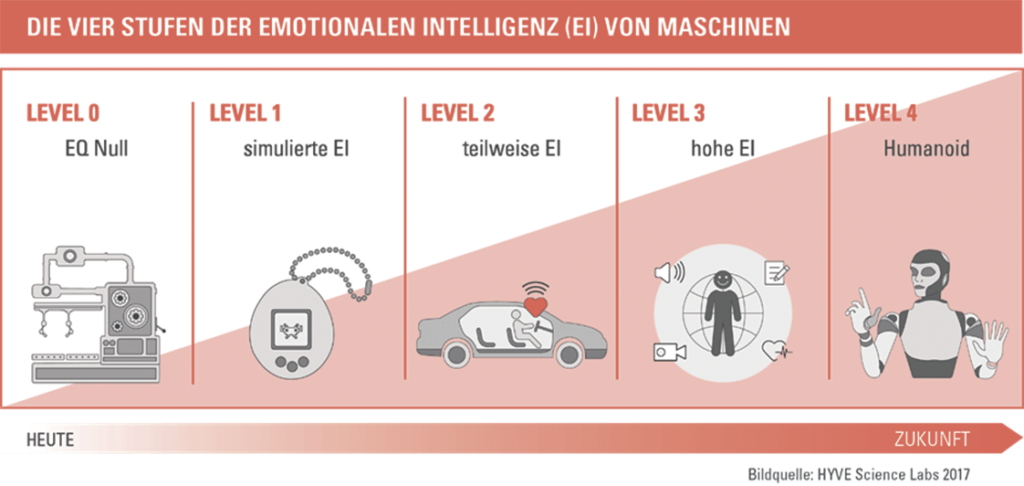

Ein innovativer Ansatz, der faszinierende Möglichkeiten bietet, die Interaktion zwischen „Mensch und Maschine“ neu zu definieren, indem Dingen, Robotern und digitalen Systemen beigebracht wird, menschliche Emotionen zu erkennen, interpretieren und darauf zu reagieren. Ein umfassendes Verständnis der Entwicklungsstufen dieser Technologie bietet das Stufenmodell von Emotion AI, das auf The Rise of Emotion AI detailliert beschrieben wird:

Das Modell wurde bereits 2017 veröffentlicht und hat sich als bewährter Rahmen zur Einordnung der Entwicklung von Emotion AI erwiesen. Emotionale Intelligenz oder der Emotionsquotient von Dingen kann in vier Levels klassifiziert werden. Level 0 steht für einen EQ von Null.

Tatsächlich sehen wir Anwendungen auf Level 2 (teilweise Emotionale Intelligenz (EI)) bereits in der Praxis, beispielsweise in der Stimmungsmessung bei Serienfahrzeugen. Auch Level 3 (hohe EI) ist in greifbarer Nähe, besonders in Bereichen wie Gaming, bei dem die Einbeziehung von Emotionen relevant ist. Diese Gebiete ziehen enorme Investitionssummen an. Emotionen im Metaverse zu berücksichtigen, wird ebenso unverzichtbar sein, da man sie im digitalen Umfeld genauso wenig ausblenden kann, wie im realen Leben.

Ein pauschales Verbot zur Erkennung von Emotionen im Rahmen des AI-Acts lässt daher aufhorchen.

Zwischen Fortschritt und Privatsphäre: Der Einfluss der EU-Regulierung

Die europäische Gesetzgebung, insbesondere der EU AI Act, spielt eine entscheidende Rolle in der Gestaltung der Entwicklungspfade von Emotion AI. Diese Gesetze beeinflussen nicht nur die Forschung und Entwicklung, sondern prägen auch die Art und Weise, wie Emotion AI in realen Anwendungen zum Einsatz kommt, und werfen wichtige Fragen bezüglich des Datenschutzes und ethischer Implikationen auf.

Entwickler und Anbieter von KI-Systemen werden sich daher intensiv mit den im AI-Act angegebenen Risikokategorien auseinandersetzen müssen. Grundlegend werden folgende Risikoklassen unterschieden:

- Unannehmbares Risiko (verbotene KI-Praktiken)

- Hohes Risiko (Hochrisiko-KI-Systeme)

- Begrenztes Risiko (KI-Systeme, die für die Interaktion mit natürlichen Personen bestimmt sind)

- Minimales und/oder kein Risiko (alle anderen KI-Systeme, die nicht in den Anwendungsbereich der KI-Verordnung fallen)

Diese Einteilung ist eine sehr sinnvolle Grundidee, um Themen wie Social Scoring und dauerhafte Überwachung auf Basis biometrischer Merkmale in Europa einen Riegel vorzuschieben. Eine pauschale Einteilung der Emotionserkennung als Hochrisikoanwendung ist in der bisherigen Fassung allerdings noch als zu undifferenziert einzuordnen und wurde übrigens auch von den unterschiedlichen EU Gremien, Kommission, Rat und Parlament ursprünglich unterschiedlich bewertet. Als Beispiel für verbotene Praktiken wird häufig die Emotionserkennung am Arbeitsplatz oder in Bildungseinrichtungen zitiert. Unklar bleiben die Antworten auf eine Reihe von Fragen:

- Wer hat auf die erkannten Emotionen Zugriff: ausschließlich der Arbeitnehmer oder auch andere Gruppen oder sogar der Arbeitgeber?

- Wurden die Emotionen individuell oder lediglich gemittelt in einer großen Gruppe erfasst?

- Erfolgt ein Abgleich mit anderen Daten wie beispielweise einer biometrischen Datenbank oder anderen personenbezogenen Daten?

- Werden in real-time Anonymisierungsalgorithmen angewendet, um dem Prinzip der Datenminimierung Rechnung zu tragen? Und wenn ja, welche?

- Welche technischen und organisatorischen Maßnahmen wurden eingesetzt und handelt es sich um eine Verarbeitung in einem geschlossenen System ohne externe Zugriffsmöglichkeiten basierend auf einer Echtzeitverarbeitung auf Metadatenebene?

Es gibt Antworten auf diese Fragen, die es zulassen die Emotionserkennung in geringere Risikoklassen einzuordnen. Die technische Entwicklung ist mit einem erheblich größeren Aufwand verbunden. Dies kann im Wettbewerb aber durchaus mittel- bis langfristig als ein Vorteil gesehen werden, nach dem Motto „it’s a feature not a bug“ oder „AI-Act conform made in Europe“. Es bleibt allerdings zu hoffen, dass die Einordnung guter Lösungen dann auch gefördert und nicht pauschal blockiert wird. Nicht nur im Bezug auf die Emotionserkennung, sondern auch auf andere Einteilungen von Anwendungen in Risikoklassen die im AI-Act bisher unzureichend ausgearbeitet sind. Das soll an dieser Stelle nicht als Vorwurf interpretiert werden. Es soll nur deutlich machen, dass die Regulierung von neuen Technologien zwar irgendwo anfangen muss, sprich initial verankert werden muss, aber gleichzeitig auch die Flexibilität in sich tragen muss, Details und Varianten der Ausgestaltung unterschiedlich einzuordnen. Tut sie das nicht, stellt sie eine Innovationsbremse dar, die gleichzeitig den Menschen kein Mehr an Schutz oder Privatsphäre bietet.

Emotion AI in Aktion

Über erste Testanwendungen hinaus findet Emotion AI Anwendung in einer Vielzahl von Branchen, einschließlich der Automobilindustrie und des Gesundheitswesens. Die Technologie hat das Potenzial, die Art und Weise, wie wir mit unseren Autos interagieren oder wie Patientenbetreuung erfolgt, grundlegend zu verändern, indem sie emotionale Zustände erkennt und entsprechend reagiert.

Neben der Automobilindustrie und dem Gesundheitswesen findet Emotion AI auch in der Medien- und Unterhaltungsindustrie breite Anwendung. Hier verändert sie die Art und Weise, wie Inhalte geschaffen und konsumiert werden, indem sie eine tiefere emotionale Verbindung zwischen dem Publikum und dem Medium ermöglicht. Besonders im Bereich des „Out of Home“ Publishings, wie bei digitalen Werbetafeln und interaktiven Installationen, kann Emotion AI – unter Gewährleistung des Datenschutzes – eingesetzt werden, um die Reaktionen der Betrachter in Echtzeit zu analysieren und die Inhalte dynamisch anzupassen. Diese Technologien bieten unglaubliche Möglichkeiten zur Steigerung der Zuschauerbindung und zur Optimierung von Werbekampagnen, indem sie die emotionale Resonanz des Publikums direkt erfassen und nutzen. KI-Systeme zur Erkennung von Emotionen am Arbeitsplatz und in Bildungseinrichtungen sind allerdings ebenfalls als verboten klassifiziert. Auf der einen Seite verständlich, wenn man verhindern will, dass der Arbeitgeber ein emotionales Dauerprofil der Mitarbeiter speichert. Auf der anderen Seite verhindert man durch eine pauschale Formulierung des Verbots viele Innovationen. Beispielsweise werden damit auch die Entwicklung von Stressmanagement Apps inhibiert, die viele Menschen bräuchten, um besser und gesünder arbeiten zu können. Ähnlich wie eine Fitness App, eine Selbstmanagement App für die eigenen Emotionen, um die Emotionale Fitness zu verbessern. Auch wird die Entwicklung von Lernapplikationen, beispielsweise von Kindern die Lernschwierigkeiten haben, unterbunden. Durch die Messung des Affektiven Zustands kann man auch Flow Momente ableiten, die die Lernfähigkeit erhöhen. Weiterhin können, Stand jetzt, auch Anwendungen z.B. in Leitstellen bei der Notrufannahme oder bei kritischen Infrastrukturen nicht eingesetzt werden. Hier wäre es wichtig Hilfssysteme zu haben, die helfen, menschliche Fehler zu vermeiden, die weitreichende Folgen haben können.

Mit Einführung von Emotion AI wurde oft gedacht, es übersteigt die Grenzen der Technik und berührt die Kernaspekte menschlicher Erfahrungen und Interaktionen. Diese fortschrittlichen Systeme bieten aber die Möglichkeit, unsere Verbindung zur Technologie tiefgreifend menschlicher zu gestalten. Sie können nicht nur unsere emotionalen Reaktionen verstehen, sondern auch darauf eingehen, was im positiven Sinne neue Wege für personalisierte Dienstleistungen und Produkte eröffnet.

Weiter kann Emotion AI in der Praxis dazu beitragen, die Kundenerfahrung durch maßgeschneiderte Werbung und Kundenbetreuung zu verbessern, ohne als störend empfunden zu werden, da diese auf das jeweilige emotionale Empfinden der Nutzer abgestimmt ist. Im Gesundheitswesen könnte diese Technologie Ärzten helfen, den emotionalen Zustand ihrer Patienten besser zu verstehen, was insbesondere bei der Behandlung von psychischen Erkrankungen oder OP-Patienten von unschätzbarem Wert sein kann. Auch in Bildungseinrichtungen bietet Emotion AI die Möglichkeit, Lernumgebungen zu schaffen, die auf die emotionale Befindlichkeit der Lernenden eingehen, wodurch die Motivation und das Engagement gesteigert und letztlich die Lernerfolge verbessert werden können.

Darüber hinaus trägt Emotion AI dazu bei, dass Maschinen menschlichere Züge annehmen und sich somit unsere Interaktionen mit ihnen natürlicher und intuitiver anfühlen. Dies führt nicht nur zu einer effizienteren Nutzung der Technologie, sondern auch zu einer stärkeren Bindung und Zufriedenheit bei den Nutzern. Die technologischen Fortschritte in der Emotionserkennung versprechen eine Zukunft, in der unsere digitalen Helfer nicht nur Aufgaben für uns erledigen, sondern auch echte Unterstützer in unserem täglichen emotionalen Leben werden.

Ethik der Emotionserkennung: Ein zweischneidiges Schwert

Emotion AI bietet weitreichende Möglichkeiten, das menschliche Erleben und die Interaktion mit Technologie zu verbessern. Sie hat jedoch auch das Potenzial, tief in die Privatsphäre einzudringen und Verhaltensweisen auf eine Weise zu beeinflussen, die ethische Bedenken aufwirft. Es ist entscheidend, dass wir einen ethischen Rahmen schaffen, der sicherstellt, dass Emotion AI zum Wohl der Menschen eingesetzt wird und nicht zur Manipulation oder Überwachung missbraucht wird. Der AI-Act ist ein guter Schritt in diese Richtung unter Berücksichtigung der oben angeführten Argumente für eine weitere Ausdifferenzierung zu einer nachvollziehbaren Einteilung in Risikoklassen.

Ein spezieller Aspekt der Ethik von Emotion AI ist die Notwendigkeit, Transparenz über die Funktionsweise und die Entscheidungsfindung der Systeme zu gewährleisten. Nutzer sollten verstehen können, wie ihre Daten verwendet werden und wie diese Systeme zu ihren emotionalen Analysen kommen. Ferner ist es wichtig, Mechanismen zu entwickeln, die eine unparteiische und faire Nutzung dieser Technologien sicherstellen und diskriminierungsfreie Ergebnisse gewährleisten.

Zudem müssen wir berücksichtigen, dass der Zugang zu und die Kontrolle über Emotion AI gerecht gestaltet wird. Dies bedeutet, dass nicht nur eine kleine Gruppe von Menschen oder Unternehmen über diese mächtigen Werkzeuge verfügen darf, sondern dass breite Schichten der Bevölkerung davon profitieren sollten. Bei dem Thema Ethik in Emotion AI geht es auch darum, dass wir als Gesellschaft entscheiden müssen, welche Anwendungen akzeptabel sind, und welche Grenzen gesetzt werden sollten, um eine gesunde Balance zwischen technologischem Fortschritt und menschlichen Werten zu finden.

Abschließend lässt sich sagen, wenn die Einführung von Emotion AI dazu führt, dass unsere Technologie empathischer, personalisierter und reaktionsschneller wird und sie einem risikobewussten Entwicklungsprozess nach den Regeln des EU AI Acts folgt, sollten wir diese Technologie als Geschenk und nicht als Bedrohung sehen.

Das menschliche Handeln wird zu einem Großteil durch Emotionen gesteuert. Insofern ist es nur sinnvoll dies einzubeziehen, um Produkte und Dienste zu schaffen, die auf diese Emotionen eingehen. Durch die Weiterentwicklung und Integration in unsere Gesellschaft könnten wir eine neue Ära der Technik erleben, in der unsere digitalen Umgebungen wirklich auf unsere Bedürfnisse und Gefühle eingehen, was das menschliche Wohlbefinden erheblich steigert. Dies alles unterstreicht die Bedeutung eines verantwortungsvollen Umgangs mit dieser mächtigen Technologie, um sicherzustellen, dass sie zum Vorteil aller eingesetzt wird und dabei ethische Standards respektiert.

Somit hat „Emotion AI made in the EU“ durchaus das Potenzial sich als weltweit geschätzter Standard zu etablieren.

Du willst mehr wissen? Dich mit uns austauschen? Schreibe uns gerne an: Strategie(at)stroeer.de

Medieninhalte in diesem Blogbeitrag wurden mithilfe von KI erstellt.