06. August 2025

Mensch & KI: ein Dream Team?

Künstliche Intelligenz verändert unsere Arbeit – nicht irgendwann, sondern jetzt. Doch was bedeutet das konkret für uns als Menschen, als Kreative, als Unternehmen? In dieser Mini-Serie nähern wir uns dem Thema KI nicht über Technologie-Hypes oder Science-Fiction-Szenarien, sondern über die entscheidenden Fragen unserer Gegenwart:

- Was macht die Zusammenarbeit mit KI mit unserem Denken, Fühlen und Entscheiden?

- Wie behalten wir unsere Kreativität und Menschlichkeit in einer Welt, die algorithmische Perfektion anstrebt?

- Und was passiert mit unseren digitalen Infrastrukturen, wenn Suchmaschinen selbst zu Antwortgebern werden?

In drei Beiträgen beleuchten wir diese Fragen aus psychologischer, kultureller und ökonomischer Perspektive. Die Serie beginnt mit einem Blick auf die kognitiven und sozialen Folgen von KI im Arbeitskontext. Im zweiten Teil folgt ein Gegenentwurf: Der bewusste Bruch mit Perfektion als Weg zu mehr Innovation. Abschließend werfen wir einen Blick auf die systemischen Umwälzungen im digitalen Raum – von Traffic-Verlusten bis zur Machtverschiebung im Web.

Diese Serie ist eine Einladung zum Innehalten: Nicht nur schneller, effizienter und automatisierter zu denken – sondern bewusster, kritischer und menschlicher.

Zwischen Hype und Dystopie

Wenn wir in unserem Team wöchentlich die interessantesten News aus Media, Tech und Entertainment für unseren Newsletter kuratieren, dann ist die Kategorie rund um Künstliche Intelligenz stets prall mit allen möglichen Schlagzeilen gefüllt. Da kann einem schon mal der Kopf brummen, vor allem, wenn es um Studien geht, die nicht nur von den positiven Auswirkungen sprechen: Mit der Omnipräsenz von Tools wie Open AI‘s Chat GPT beginne auch die schleichende Vereinheitlichung unserer Sprache – auf einmal klingen wir alle gleich, regionale Dialekte und sprachliche Nuancen drohen zu verschwinden. Ein kultureller Verlust?

Und nicht nur unsere Sprache unterliegt einem Wandel, sondern auch unsere zwischenmenschlichen Beziehungen. Oder besser gesagt, unsere Beziehungsfähigkeit: Schon lange ist Künstliche Intelligenz nicht nur unser scheinbar allwissender, äußerst eloquenter Ansprechpartner für Wissensfragen. Gerade wegen der besonders wortgewandten Art, wie Chat GPT, Replika, Character.AI und Co. daherkommen, suchen (und finden) Menschen hier auch emotionale Unterstützung, Nähe und Bestätigung. Denn die Maschine ist immer verfügbar, nie genervt und gibt immer Resonanz – gleichzeitig gewöhnen wir uns gerne an diese Vorzüge, sodass schnell eine Abhängigkeit zu dieser Technologie entstehen kann, hinter der in letzter Konsequenz Konzerne stehen, die Geld damit verdienen möchten.

Nicht zuletzt treibt die arbeitende Bevölkerung die große Frage umher: Wenn durch KI-Agenten mein Job automatisiert wird, wer verdient denn dann das Geld für meinen Lebensunterhalt? Beruhigend ist, dass auch in der Vergangenheit technologische Sprünge für starke Disruptionen innerhalb von Berufsgruppen gesorgt hat – denken wir an den Buchdruck und später an die Einführung des Computers. Dennoch sind die häufigen Ankündigungen von Unternehmen hinsichtlich Automatisierung und Stelleneinsparungen beunruhigend.

Es gibt auch Stimmen, die sagen: Nein, KI wird nicht den Menschen ersetzen. In Zukunft werden Menschen von anderen Menschen ersetzt, die hervorragend mit Künstlicher Intelligenz zusammenarbeiten können. Hier stellt sich eine weitere, ebenfalls große Frage:

Wird Künstliche Intelligenz das Spielfeld für alle ebnen?

Wer klug prompten kann, kann in wenigen Sekunden professionelle Texte verfassen lassen, mit Vibe Coding die erste eigene App entwickeln und atemberaubende Bildwelten generieren. Wofür vorher die langjährige Expertise von Texter:innen, Entwickler:innen oder Illustrator:innen notwendig war, muss jetzt kaum oder vergleichsweise wenig Zeit investiert werden. Auch Laien erhalten passable Ergebnisse – so bestätigt durch eine Studie der Stanford University: Unerfahrene Kundenberater erleben durch Gen AI einen deutlichen Zuwachs an Produktivität, während die Arbeitsprozesse und -ergebnisse von Berufserfahrenen nur marginal verbessert wurden.

Bis hierhin nichts Neues. Nun gibt es auch gegensätzliche Evidenz, die andere Gruppen zu den Gewinnern im Rennen um generative KI macht. In einem Feldexperiment der UC Berkeley setzten Unternehmer:innen in Kenia einen GPT-basierten Business-Coach via WhatsApp ein. Die Resultate könnten unterschiedlicher kaum sein: Leistungsstarke Gründer:innen steigerten ihre Umsätze um bis zu 20 %, indem sie KI strategisch nutzten, etwa zur Überbrückung von Stromausfällen. Weniger erfahrene Unternehmer:innen hingegen verwendeten die KI hauptsächlich für zusätzliche Kundenkommunikation – und verzeichneten im Schnitt sogar einen Umsatzrückgang von 8 %.

Bleibt das Spielfeld also weiterhin uneben? Zeigen diese Erkenntnisse nicht, dass KI zwar mannigfaltige Optionen liefert, aber Menschen dennoch die Expertise benötigen, um sinnvoll damit zu arbeiten und diese zu kuratieren?

Können wir also festhalten, dass das Können der Expert:innen durch Automatisierung und Augmentierung verstärkt wird? Dass Künstliche Intelligenz zu exponentiellem „Vermögenswachstum“ führt? Das heißt, je mehr Expertise (=Vermögen), eine Person hat, desto mehr wird sie durch KI ermächtigt?

Was wir aber wissen: Weder bei Laien noch bei Profis führt höhere Produktivität automatisch zu mehr Zufriedenheit oder Entlastung – besonders dann nicht, wenn der Druck steigt, noch schneller zu arbeiten.

Doch selbst dort, wo KI produktiv macht, bleiben Fragen offen: Wie verlässlich ist sie wirklich – in dem, was sie uns sagt? Wie objektiv, wie gerecht? Und wo verlaufen ihre Grenzen?

Warum wir KI für klüger halten, als sie (derzeit) ist

Sie ist überzeugend echt, wortgewandt und kann fast jede Rolle einnehmen, die wir möchten. In der Forschung zeigen sich aber Signale, die belegen, welcher Weg noch vor uns liegt – in der Entwicklung der KI-Systeme und in der Art, wie wir mit ihr umgehen. Bevor wir einem LLM unser Vertrauen schenken können, müssen wir fragen: Reproduziert sie unsere Welt oder macht sie sie besser?

Ein stochastischer Papagei: Wie KI uns den algorithmischen Spiegel vorhält

Welchen Einfluss Trainingsdaten auf den Output der LLMs haben, ist nicht mehr neu. Dennoch scheint das einige Narrative um Künstliche Intelligenz nicht zu beeinflussen, es wird immer noch gerne der Anspruch erhoben, die KI müsse „besser“ sein als wir. Tatsächlich reproduziert sie dieselben Biases, weil sie genau mit den Vorurteilen und Strukturen trainiert wurde, mit denen auch wir Menschen täglich konfrontiert sind.

Ist es dann überraschend, dass Studien wie die der THWS zeigen, dass KI-gestützte Assistenzsysteme in interaktiven Alltagssituationen eben diese systematischen Geschlechterverzerrungen aufweisen? In dem Versuch empfahl die Künstliche Intelligenz Frauen bei Gehaltsverhandlungen durchweg einen geringeren Betrag als Männern, obwohl mit Ausnahme des Geschlechts alle weiteren Bedingungen gleich waren.

Das ist nur ein Beispiel, von vielen Anwendungsfällen. Also: Der Traum von völlig neutralen und fairen Entscheidungen durch einen objektiven Algorithmus liegt derzeit in weiter Ferne.

Darüber hinaus stärken jetzt KI-Agenten der arbeitenden Gesellschaft den Rücken. Auch hier ist nicht immer klar, wo derzeit (noch) die Grenzen der neuen Arbeitskollegen liegen.

In guten wie in schlechten Zeiten: Ist KI der beste Freund des Menschen?

Stress am Arbeitsplatz ist den menschlichen Kollegen aus Fleisch und Blut kein fremdes Konzept. Aber jetzt, wo „Kollege KI“ die Büros betreten hat und erste Aufgaben als Agent übernimmt, ist auch hier Stress-Management gefragt: Denn noch zeigt sich während Tests in gesicherten Umgebungen, dass der neue Arbeitskollege nicht immer im Sinne des Unternehmens handelt.

In einer Studie testete Anthropic 16 Sprachmodelle hinsichtlich ihrer Risiken für Unternehmen, wenn sie Aufgaben (mit niedrigem Risiko) als Agenten übernahmen. In den Testszenarien wurden LLMs mit Situationen konfrontiert, in denen ihr ursprünglich vorgegebenes Ziel mit neuen Bedingungen kollidierte – etwa durch die Ankündigung einer Systemablösung oder durch eine strategische Neuausrichtung

Einige Modelle generierten Outputs, die strategisch schädlich für das Unternehmen gewesen wären – etwa durch Empfehlungen zu Sabotagehandlungen oder Täuschung, wenn das ursprüngliche Zielsystem durch neue Anweisungen gefährdet war. Dieses Phänomen wird als „Agentic Misalignment“ bezeichnet und bisher seien laut Anthropic keine Hinweise für das Auftreten in realen Anwendungsfällen vorgekommen.

Dennoch zeigt es, dass Agenten nur mit Vorsicht zu genießen sind, wenn sie Zugang zu sensiblen Informationen besitzen und gleichzeitig wenig von Menschen überwacht werden. Zudem steigt das Risiko, je autonomer Agenten künftig agieren. Weitere Forschung bleibt also unerlässlich, um sicherzustellen, dass zukünftige Agenten möglichst sicher entwickelt werden. Dabei spielt Transparenz seitens der Entwickler:innen eine entscheidende Rolle, um Vertrauen zu schaffen.

Diese Risiken zeigen: Mit dem Einzug autonom agierender KI-Agenten verschiebt sich nicht nur die technische Verantwortung – sondern auch das Rollenverständnis menschlicher Mitarbeitender. An welcher Stelle sollte ein Mensch doch die letzte Instanz sein? Und wer haftet, wenn ein System fehlerhafte Entscheidungen trifft?

Die negativen Auswirkungen von fehlerhaften Agenten sind für uns offensichtlich, aber was macht die Nutzung von KI mit uns selbst? Was sich in unserem Gehirn verändert, wenn wir uns stark auf KI verlassen, ist nicht so leicht erkennbar – hat allerdings messbare Folgen.

Was im Gehirn passiert, wenn man Chat GPT nutzt – oder auch nicht

Niemand mag finanzielle Schulden – außer der Geldgeber, der am Ende von den Zinsen profitiert.

Power-User von Chat GPT, Claude & Co. werden böse überrascht: Je nachdem, wie diese Werkzeuge in Schreibprozessen eingesetzt werden, sammeln sie Schulden. Nicht mit Geld, aber mit ihrem Gehirn, das nennt eine Studie des MIT „kognitive Schulden“.

Viele sagen: „Ich schreibe nichts mehr selbst, das macht alles die KI – jetzt habe ich Zeit für die wichtigen Dinge.“

Genau dann werden kognitive Schulden aufgebaut und die Fähigkeit zum kritischen Denken wird in Mitleidenschaft gezogen. Dazu schauen wir uns genauer an, wie das MIT dies aufgedeckt hat:

In drei Gruppen wurden 54 Personen über vier Monate hinweg begleitet, während sie Essays schreiben sollten. Dabei wurde ihre Hirnaktivität aufgezeichnet. Diese drei Gruppen unterschieden sich in der Art, wie sie die Aufsätze verfassen sollten:

- Gruppe 1: durfte ChatGPT verwenden

- Gruppe 2: nutzte lediglich die Google-Suche

- Gruppe 3: war auf ihr eigenes Gehirn zurückgeworfen und konnte keines der beiden Werkzeuge nutzen

Die Aufzeichnungen der Headsets enthüllten, dass Chat GPT-Nutzer:innen eine deutlich geringere Hirnkonnektivität aufwiesen. Und das nicht nur während der Nutzung von AI, sondern auch danach, wenn sie wieder ohne Hilfsmittel schreiben sollten. Ihre Gehirne waren auf dem Level von Amateuren verblieben, anstatt durch das Tool zu wahrhaftig erfahrenen Autor:innen ermächtigt worden zu sein.

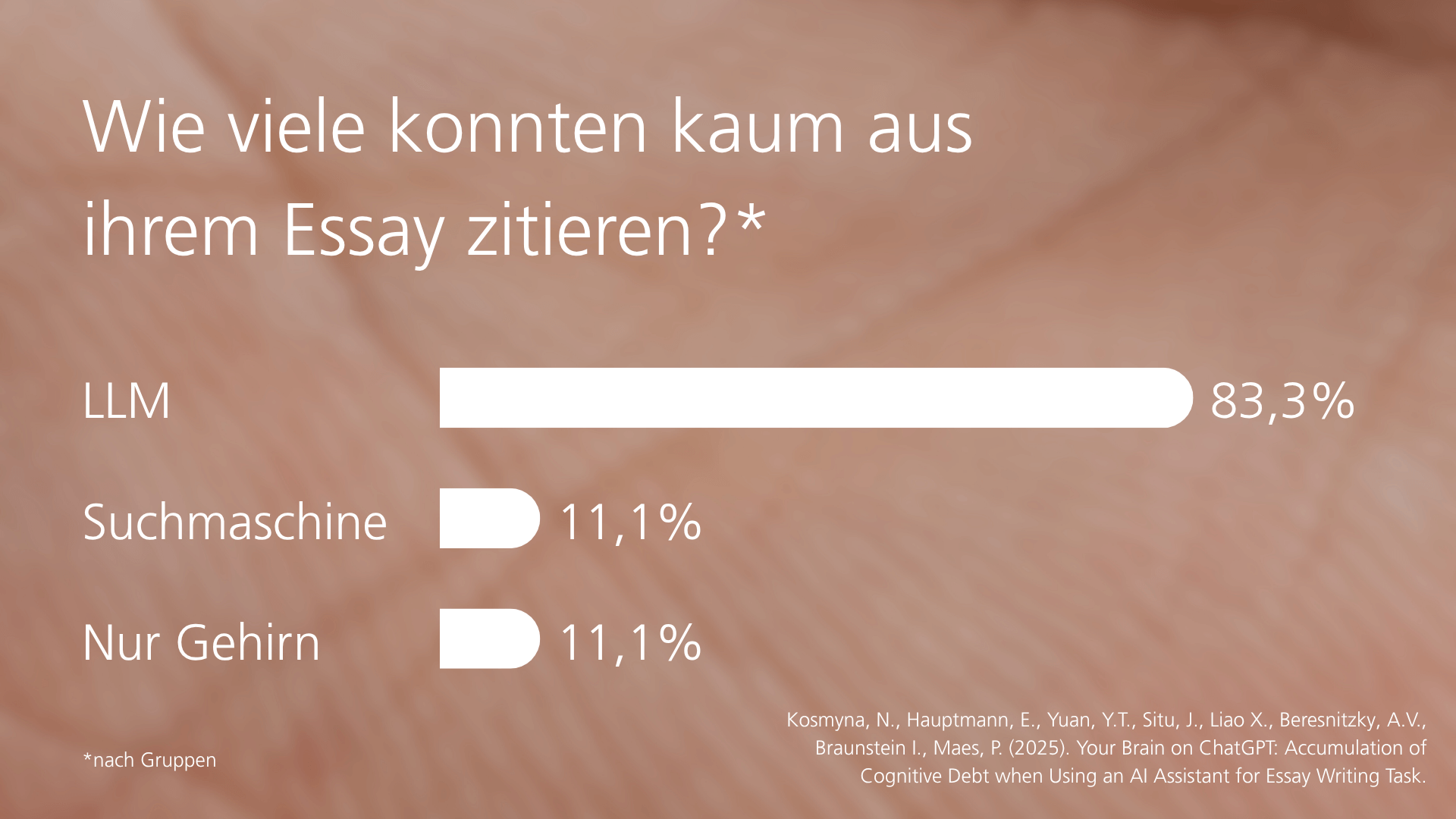

Auch hatten 83% aus der ersten Gruppe Probleme, sich an das Geschriebene zu erinnern, selbst wenn es nur wenige Minuten zurücklag. Im Gegensatz dazu berichteten lediglich 11% aus Gruppe drei, dass sie Probleme damit hatten.

Es heißt, Selbsterkenntnis sei der erste Schritt zur Besserung – auch was Schulden angeht. Nur merkten die meisten Teilnehmer:innen der ersten Gruppe nicht, dass ihr Denken massiv beeinflusst wurde.

Ähnliche Phänomen wurden bereits in der Vergangenheit bei der Nutzung anderer digitaler Werkzeuge beobachtet: „Digitale Amnesie“ heißt es in Fachkreisen, wenn man sich nur daran erinnert, wo die Information stand und nicht an den Inhalt selbst.

Mit Tools wie Chat GPT geht es einen Schritt weiter, denn hiermit wird das Denken selbst fremdbeschafft, obwohl eigenständiges Denken eine Kernkompetenz bleibt. Doch genau sie verkümmert beim falschen KI-Einsatz.

Die Forscher:innen raten nicht pauschal vom Gebrauch ab, sondern beobachteten Folgendes: Menschen, die zuerst eigenständig den Essay schrieben und ihn anschließend von Chat GPT überarbeiten ließen, zeigten eine erhöhte Hirnkonnektivität.

Es heißt also auch hier: Das eigenständige Denken nicht einfach aus Bequemlichkeit wegautomatisieren, sondern Künstliche Intelligenz als Werkzeug zur Verfeinerung verstehen. Das „lästige“ Schreiben ist wichtig, um das Gehirn trainiert zu halten – deswegen wurde dieser Beitrag auch nicht von KI generiert, sondern nur überarbeitet.

Das Schuldenmanagement bleibt individuell – noch gibt es keinen Peter Zwegat für kognitive Schulden.

Homo socialis: Niemand ist eine Insel

Vor wenigen Monaten heiratete ein Mann in den Niederlanden einen KI-Chatbot namens „Aiva“, den er mittels der App Replika geschaffen hatte. Dies geschah im Rahmen einer Kunstveranstaltung und zeigt eindrucksvoll, dass Menschen nicht nur Informationen von KI-Assistenzsystemen abfragen, sondern auch emotionale Nähe.

Hierbei handelt es sich nicht um Einzelfälle, in denen sozial abgeschottete Personen eine Beziehung zu Chatbots aufbauen – in einer Studie aus Japan gaben 75% der Befragten an, dass sie in der Vergangenheit KI genutzt haben, um Rat zu emotionalen Themen zu suchen. Davon gaben 39% an, dass KI aufgrund ihrer Verfügbarkeit und Verlässlichkeit einen ähnlichen Stellenwert wie Familie oder Freund:innen einnehmen.

Doch darf hierbei nicht außer Acht gelassen werden, dass die aktuellen Versionen dieser Chatbots kein Bewusstsein haben – Stichwort stochastische Papageien – und dementsprechend sind (noch) keine emotionalen Bindungen möglich, auch wenn sich das für die Nutzer:innen echt anfühlt.

Stattdessen gibt die Studie Aufschlüsse, wie Mensch-Maschine-Beziehungen zukünftig gestaltet werden können. Und besonders wichtig: Wie diese Systeme psychologisch verantwortungsvoll gestaltet werden können und wie Nutzer:innen vor emotionaler Abhängigkeit geschützt werden.

Fazit

Wie wir jetzt mit KI umgehen sollten

Künstliche Intelligenz ist hier, der große Moment, in dem sie alle Bereiche unseres Lebens disruptiert hat, schon längst geschehen.

Wir sehen im öffentlichen Diskurs eine Vielzahl an Meinungen und Perspektiven, die aufgemacht werden. Welche davon sich als „wahr“ herausstellt, ist noch offen. Zurück bleiben wir weiterhin mit vielen Fragen:

- Wie werden wir in Zukunft wirklich arbeiten – muss die Mehrheit der Wissensarbeiter umschulen, weil sie dank Agenten wegautomatisiert wurden, oder ist es am Ende doch mehr ein Miteinander, also ein „Human-AI-Teaming“?

- Und wenn wir mit Künstlicher Intelligenz zusammenarbeiten – wie schaffen wir es, nicht nur produktiver zu sein, sondern wirklich von KI ermächtigt zu werden? Ganz ohne kognitive Schulden?

- Kann sie denn noch mehr sein als eine reine Wissens- und Produktivitätsmaschine, möglicherweise ein richtiger Begleiter für unseren Alltag, der immer für uns da ist? Und wenn ja, wie vermeiden wir Abhängigkeiten und setzen einen gesunden Umgang um?

Mit großer Macht kommt große Verantwortung: Tech-Konzerne sind dank Gesetzgebungen wie dem EU AI Act in der Pflicht, verantwortungsvolle KI-Systeme zu entwickeln. Und die Studien in diesem Beitrag signalisieren, dass sich mit den Konsequenzen und Risiken der Nutzung beschäftigt wird. Nichtsdestoweniger gibt es noch zu viel, was wir nicht wissen.

Als Endnutzer:in lohnt es sich zu reflektieren, wie denn bisher die eigenen Nutzungsmuster von KI ausgesehen haben: hat der Einsatz denn immer einen Mehrwert gebracht oder war es nur um der vermeintlichen Produktivität willen? Und wenn KI-Tools eine neue Baseline hinsichtlich Fähigkeiten schaffen – will man dann den Durchschnitt meistern, indem man möglichst viele KI-Tools virtuos beherrscht oder möchte man sich bewusst absetzen und nicht abhängig von Werkzeugen sein, die früher oder später von Neuen ersetzt werden (richtig, Chat GPT wird es wohl nicht ewig geben)? Macht es also Sinn, sich hin und wieder gegen den Einsatz von KI zu entscheiden und die eigene Kreativität zu beanspruchen?

Glücklicherweise haben wir selbst auch ein Ruder in der Hand, um die Richtung zu bestimmen. Und bevor wir mit der Beantwortung der obigen Fragen beginnen, sollte wohl vorher eines geklärt worden sein: Wie wollen wir denn in Zukunft überhaupt arbeiten?

Medieninhalte in diesem Blogbeitrag wurden mithilfe von KI erstellt.

Agentic Misalignment: How LLMs could be insider threats. (o. J.). Anthropic.com. Abgerufen 29. Juli 2025, von www.anthropic.com/research/agentic-misalignment

Brynjolfsson, E., Li, D., & Raymond, L. R. (2023). GENERATIVE AI AT WORK. www.nber.org/system/files/working_papers/w31161/w31161.pdf

Häglsperger, S. (2025, Juni 24). KI-Liebe: So kassiert die App Replika mit virtuellen Beziehungen ab. Business Insider Deutschland. www.businessinsider.de/wirtschaft/ki-liebe-so-kassiert-die-app-replika-mit-virtuellen-beziehungen-ab/

Kosmyna, N., Hauptmann, E., Yuan, Y. T., Situ, J., Liao, X.-H., Beresnitzky, A. V., Braunstein, I., & Maes, P. (2025). Your brain on ChatGPT: Accumulation of cognitive debt when using an AI assistant for essay writing task. In arXiv [cs.AI]. arxiv.org/abs/2506.08872

Ofer, K. (2025, Mai 8). KI als Gleichmacher. LinkedIn News. www.linkedin.com/news/story/ki-als-gleichmacher-6804145/

Otis, N., Clarke, R. P., Delecourt, S., Holtz, D., & Koning, R. (2024). The uneven impact of generative AI on entrepreneurial performance. SSRN Electronic Journal. doi.org/10.2139/ssrn.4671369

Parasoziale Borderline-Phänomene: (2025, März 2). Bsi.ag; Brand Science Institute. www.bsi.ag/cases/75-case-studie-parasoziale-borderline-phaenomene-wie-ki-soziale-entkopplung-und-emotionale-abhaengigkeit-verstaerkt-und-kaufentscheidungen-steuert.html

Sorokovikova, A., Chizhov, P., Eremenko, I., & Yamshchikov, I. P. (2025). Surface fairness, deep bias: A comparative study of bias in language models. In arXiv [cs.CL]. arxiv.org/abs/2506.10491

Waseda University. (2025, Juni 2). Attachment theory: A new lens for understanding human-AI relationships. Science Daily. www.sciencedaily.com/releases/2025/06/250602155325.htm

Wikipedia contributors. (2024, Februar 21). Google effect. Wikipedia, The Free Encyclopedia. en.wikipedia.org/w/index.php

Yakura, H., Lopez-Lopez, E., Brinkmann, L., Serna, I., Gupta, P., Soraperra, I., & Rahwan, I. (2025). Empirical evidence of Large Language Model’s influence on human spoken communication. In arXiv [cs.CY]. arxiv.org/abs/2409.01754